随着人工智能(AI)技术的快速发展,训练大规模模型已成为行业常态。单个计算节点的资源限制常导致训练时间过长,甚至无法完成任务。分布式训练技术应运而生,通过将计算任务分解到多个节点并行处理,有效提升了训练效率和模型性能。

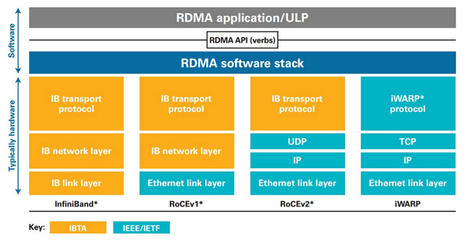

分布式训练的核心方法包括数据并行和模型并行。数据并行将训练数据分割到不同节点,每个节点持有完整的模型副本,通过梯度同步(如使用All-Reduce算法)实现参数更新;模型并行则将模型结构拆分到不同节点,适用于超大规模模型(如GPT-4),解决单个设备内存不足的问题。混合并行策略结合了两者优势,例如在Megatron-LM等框架中广泛应用。关键技术如参数服务器架构和All-Reduce通信优化(如Ring-AllReduce)进一步降低了通信开销。

在人工智能应用软件开发中,分布式训练技术显著加速了产品迭代。以智能语音助手为例,开发团队可利用Horovod或PyTorch Distributed框架,在GPU集群上并行训练声学模型,将数周的训练时间缩短至几天。分布式训练支持更大规模数据的处理,提升了模型在复杂场景下的准确性,如自动驾驶系统中的视觉识别模块。开发者需注意数据分布一致性、节点故障恢复等挑战,并借助Kubernetes等工具实现弹性资源调度。

随着异构计算和联邦学习等技术的融合,分布式训练将进一步推动AI应用软件的创新,帮助企业在医疗、金融等领域实现高效智能化转型。