随着信息技术的飞速发展,信息系统安全问题日益突出,传统的安全防护手段已难以应对日益复杂的网络攻击和威胁。人工智能技术的崛起,为信息系统安全带来了革命性的变革。通过机器学习、深度学习、自然语言处理等AI技术,安全防护系统能够实现智能化、自动化和自适应,大幅提升安全防御的效率和准确性。

在信息系统安全领域,人工智能的应用主要体现在以下几个方面:

威胁检测与预警。AI可以通过分析海量的网络流量、日志数据和用户行为,建立正常行为基线,并实时识别异常模式。例如,利用无监督学习算法,系统可以自动发现未知的新型攻击,如零日漏洞利用或高级持续性威胁(APT),从而在攻击造成实际损害前发出预警。

恶意软件分析与防御。传统的特征码检测方式难以应对快速变种的恶意软件。基于机器学习的静态和动态分析技术,可以提取恶意软件的深层特征,实现高精度的分类与检测。深度学习模型如卷积神经网络(CNN)在图像化恶意代码识别中表现出色,能够有效区分恶意与良性软件。

身份认证与访问控制。人工智能可以强化生物特征识别(如人脸、声纹)、行为生物识别(如打字节奏、鼠标移动模式)等多因素认证系统。通过持续学习用户行为,AI系统能够动态评估访问风险,实现自适应访问控制,防止未经授权的访问。

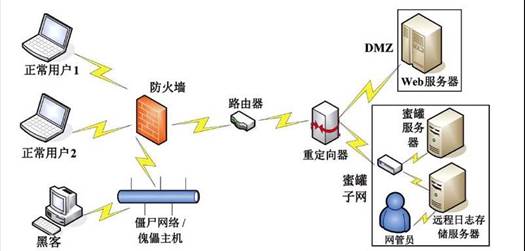

安全自动化与响应。AI驱动的安全编排、自动化与响应(SOAR)平台,可以自动处理警报、调查事件并执行响应动作,如隔离受感染设备、阻断恶意IP地址,从而缩短响应时间,减轻安全人员的工作负担。

在人工智能应用软件开发方面,构建高效、可靠的AI安全系统需要综合多学科知识。开发流程通常包括:

- 数据收集与预处理:安全数据的质量直接影响模型性能。开发者需要从防火墙、入侵检测系统、终端设备等来源收集多样化数据,并进行清洗、标注和增强,以构建高质量的训练数据集。

- 模型选择与训练:根据具体安全任务(如异常检测、分类、预测),选择合适的AI算法,如随机森林、支持向量机(SVM)、循环神经网络(RNN)或Transformer模型。训练过程中需注重模型的泛化能力,避免过拟合,并考虑计算效率与实时性要求。

- 系统集成与部署:将训练好的AI模型集成到现有安全基础设施中,提供API接口或嵌入式模块。部署时需考虑可扩展性、可靠性和隐私保护,例如采用联邦学习在分布式环境中训练模型而不暴露原始数据。

- 持续优化与评估:安全威胁不断演变,AI模型需要定期更新和再训练以保持有效性。通过A/B测试、性能监控和反馈循环,开发者可以持续改进系统,应对新型攻击手法。

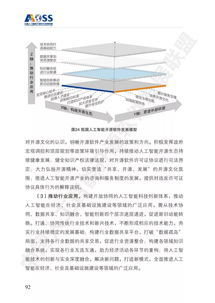

人工智能在安全领域的应用也面临挑战,包括对抗性攻击(如精心构造的输入欺骗AI模型)、数据隐私问题、算法可解释性不足以及高计算资源需求。因此,未来的开发方向应聚焦于增强AI系统的鲁棒性、开发可解释AI(XAI)技术、探索隐私计算方案,并推动轻量化模型以适应边缘计算环境。

人工智能正深刻改变信息系统安全的格局,通过智能化的威胁感知、决策和响应,为构建主动、自适应的安全防御体系提供了强大支撑。与此AI应用软件的开发需要紧密结合安全实践,不断迭代创新,以应对日益严峻的网络安全挑战。